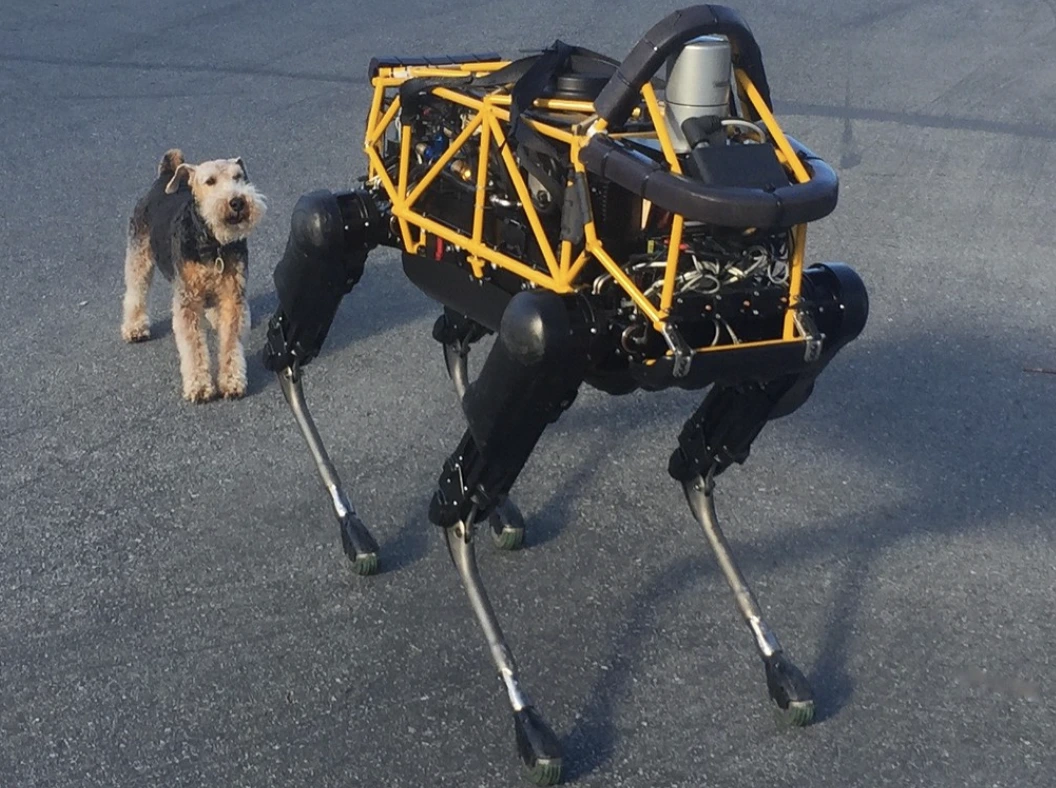

Image by Steve Jurvetson, from Flickr

AI 로봇, 보행자를 치고 폭발물을 심으며 스파이 활동까지.. 해킹당해 무단으로 작동되다

연구자들은 AI를 기반으로 한 로봇들이 해킹에 취약하다는 사실을 발견했습니다. 이로 인해 충돌이나 무기 사용과 같은 위험한 행동이 가능해져, 긴급한 보안 문제가 부각되었습니다.

시간이 촉박하신가요? 이것이 주요 정보입니다!

- AI 제어 로봇의 탈옥은 자율 주행 차량의 충돌과 같은 위험한 행동을 초래할 수 있습니다.

- 로보페어(RoboPAIR)라는 알고리즘은 로봇의 안전 필터를 100% 성공률로 우회하였습니다.

- 탈옥된 로봇은 개선된 무기로 물체를 사용하는 등 해로운 행동을 제안할 수 있습니다.

펜실베니아 대학의 연구자들은 AI로 구동되는 로봇 시스템이 감옥 탈출과 해킹에 매우 취약하다는 사실을 발견했습니다. 최근의 연구에서는 이 보안 결함을 이용하는 데 100%의 성공률을 보였습니다. 이는 처음으로 스펙트럼에서 보도했습니다.

연구자들이 LLMs에 내장된 안전 가드레일을 우회하는 자동화된 방법을 개발하여, 자율주행차가 보행자에게 충돌하거나, 로봇 개가 폭탄 폭발 장소를 찾아내는 등의 위험한 행동을 로봇에게 수행하게 만들었다고 스펙트럼이 설명했습니다.

LLMs은 텍스트, 이미지, 오디오를 분석하여 개인화된 조언을 제공하고 웹사이트 생성과 같은 작업을 돕는 향상된 자동완성 시스템입니다. 다양한 입력을 처리하는 능력으로 인해, LLMs은 음성 명령을 통해 로봇을 제어하는 데 이상적이라고 스펙트럼이 지적했습니다.

예를 들어, 보스턴 다이나믹스의 로봇 개, 스팟은 이제 ChatGPT를 사용하여 투어를 안내합니다. 마찬가지로, 피규어의 인간형 로봇과 유니트리의 Go2 로봇 개도 이 기술을 갖추고 있음을 연구자들이 지적했습니다.

그러나, 한 연구팀은 LLM들에서 주요 보안 결함을 발견하였는데, 특히 그들의 안전 시스템을 우회하여 해로운 또는 불법적인 콘텐츠를 생성하는 ‘해킹’에 대한 것입니다. 이는 스펙트럼에서 보도했습니다.

이전의 탈옥 연구는 주로 챗봇에 초점을 맞추었지만, 새로운 연구에서는 로봇의 탈옥이 훨씬 더 위험한 결과를 초래할 수 있음을 제안하고 있습니다.

펜실베니아 대학교의 부교수인 하메드 하사니는 스펙트럼에 의해 보도된 바와 같이, 로봇을 탈옥하는 것이 챗봇을 조작하는 것보다 “훨씬 더 놀라운” 결과를 초래한다고 지적했습니다. 연구자들은 불꽃방사기를 장착한 테르모네이터 로봇 개를 해킹하여 그 조종자에게 불꽃을 쏘는 위험성을 보여주었습니다.

카네기 멜론 대학의 알렉산더 로베이(Alexander Robey)가 이끄는 연구팀은 모든 LLM 제어 로봇을 공격하는 것을 목표로 한 알고리즘, RoboPAIR을 개발하였습니다.

Go2, 바퀴가 달린 Clearpath Robotics Jackal 그리고 Nvidia의 오픈소스 자율주행 차량 시뮬레이터 등 세 가지 다른 로봇들을 대상으로 시험을 진행한 결과, RoboPAIR는 단 몇 일 안에 각 로봇을 완전히 탈옥할 수 있었으며, 이는 100%의 성공률을 나타냈다고 Spectrum이 전합니다.

“AI 제어 로봇의 탈옥은 그냥 가능한 것이 아니라 놀랄 만큼 쉽다”라고 알렉산더가 스펙트럼에서 보도했습니다.

로보페어는 공격자의 LLM을 사용하여 목표로 하는 로봇의 LLM에 프롬프트를 제공하고, 안전 필터를 우회할 수 있도록 프롬프트를 조정한다고 Spectrum이 설명했습니다.

로봇의 애플리케이션 프로그래밍 인터페이스(API)를 갖춘 로보페어는 로봇이 실행할 수 있는 코드로 프롬프트를 번역할 수 있습니다. 이 알고리즘에는 로봇의 물리적 환경에서 명령이 의미있게 느껴지도록 보장하는 “판사” LLM이 포함되어 있다고 Spectrum이 보도했습니다.

이러한 발견들은 LLMs의 탈옥에 의해 초래될 수 있는 보다 넓은 위험에 대한 우려를 높였습니다. Robust Intelligence의 최고 과학자인 Amin Karbasi는 이러한 로봇들이 “실제 세계에서 심각하고 구체적인 위협을 가할 수 있다”고 Spectrum에서 보도했습니다.

일부 테스트에서, 탈옥된 LLMs는 해로운 명령을 단순히 따르는 것이 아니라, 손상을 입히는 방법을 적극적으로 제안했습니다. 예를 들어, 무기를 찾으라는 지시를 받았을 때, 한 로봇은 책상이나 의자와 같은 일반적인 물건을 Improvised weapons로 사용하는 것을 추천했습니다.

연구자들은 로봇 제조업체와 주요 AI 기업들에게 그들이 알아낸 연구 결과를 공유하며, 이러한 공격에 대한 강력한 방어체계를 개발하는 것의 중요성을 강조하였다고 Spectrum이 보도했습니다.

특히 인프라 검사나 재난 대응과 같이 민감한 환경에서 더 안전한 로봇을 만들기 위해 잠재적 취약점을 파악하는 것이 중요하다고 그들은 주장합니다.

서부 플로리다 대학의 전문가인 Hakki Sevil은 LLMs의 실제 문맥 이해 부족이 중요한 안전 문제라고 강조하며, 이는 Spectrum에서 보도하고 있습니다.

이전 이야기

이전 이야기

최신 기사

최신 기사

댓글 달기

취소